以太坊联合创始人 Vitalik Buterin 在参与 TOKEN 2049 时,发表了题为“What Excites Me About the Next Decade”(未来十年令我兴奋的事情)的主题演讲,其认为当前加密行业已不再处于早期阶段,但在“实际可用”方面仍处于早期,以太坊需要满足主流采用的需求。以下为 Vitalik 本次演讲的原文,经Odaily星球日报编译精简,enjoy~

加密行业已不再是早期

很多时候,当人们和我谈论目前面临的一些挑战时,他们会倾向于说:“你知道的,现在还处于早期阶段,我们仍在构建基本的基础设施,看看互联网实现花了多长时间。”自比特币推出以来,人们一直这么说,但我认为现在是关注产品的时候,加密已经不再处于早期阶段。

比特币已经存在了 15 年,以太坊已经存在了 10 多年。我们看到像 ChatGPT 这样的事物从完全不存在发展到突然崛起,完全改变了每个人对人工智能的理解。

所以我们必须问自己一个问题,我们应该如何看待这一切?我觉得这个问题答案是,我们并不处于加密行业的早期,但在加密行业“实际可用”方面确实还很早。所以让我通过回顾一下历史来解释我的意思。

记得在 2013 年,我们的团队,当时我们都对比特币感到兴奋,认为比特币是支付领域的下一个重大革命,建设者们做出了非常惊人和认真的努力,试图让世界各地的普通商家开始接受比特币。谁还记得柏林的 Room 77 ?那里有一家接受比特币支付的餐厅,这实际上是我去的第一家比特币餐厅。在 2013 年,你可以自豪的说自己是一家接受比特币的餐厅,人们都会对此感到非常兴奋。

那么接下来发生了什么?我们可以稍微再深入一些,我记得我在 2021 年第一次前往阿根廷时,我注意到的第一件事是,全国范围内的人不仅对加密货币感到非常兴奋,而且还在积极大规模地使用它。

有一次圣诞节我四处走动,我进了一家开门的咖啡店,店主知道我是谁,并允许我使用加密货币支付。虽然他们能使用加密货币,但没有积极使用去中心化技术。

他们使用的是哪种技术?事实证明,阿根廷当地人都在使用金融转账。因为金融转账是即时和免费的。我认为这最终是同一个问题——费用,至少它扼杀了数字货币浪潮:“让每个人都接受比特币作为一种货币”。

如果你还记得加密货币一开始的营销,它谈论了很多关于西联汇款、Paypal、信用卡的费用,他们向客户收取的费用非常高。但后来比特币本身的费用上涨到了 50 美元。

而以太坊的费用也在上涨,我在以太坊上支付的最高费用实际上是用于隐私服务交易。但不可否认的是,gas 价格上涨了,每次我进行操作时,Twitter 上的评论也很多。因此,隐私协议具有非常好的产品市场契合度,但一些交易费用约为 800 美元。所以费用太贵基本上是很多东西失败的原因。

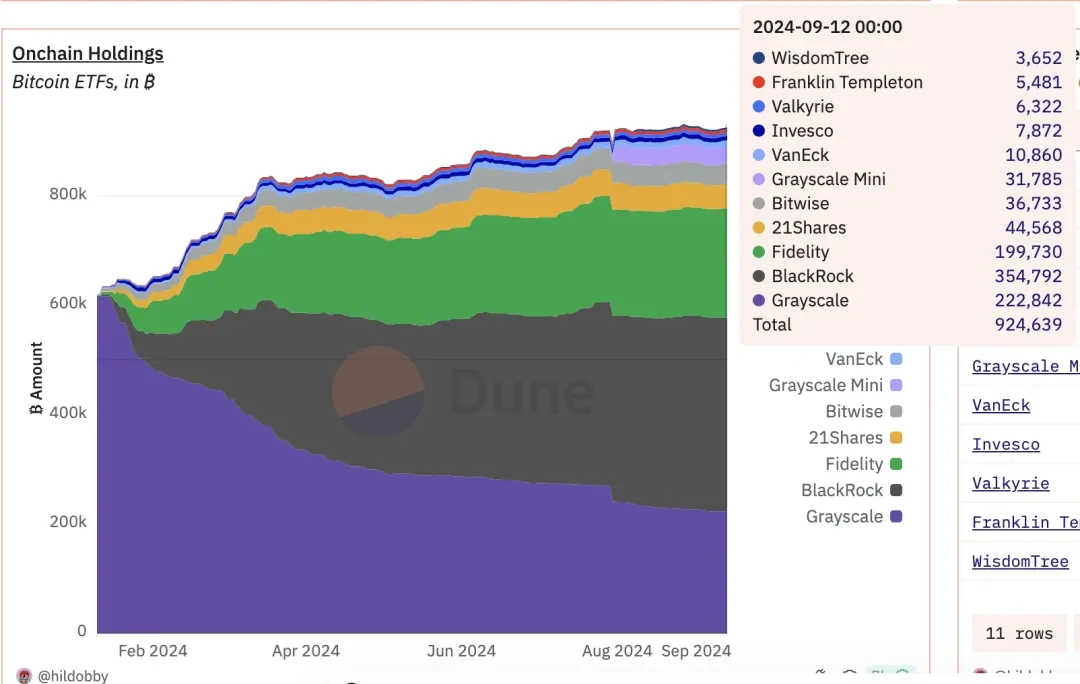

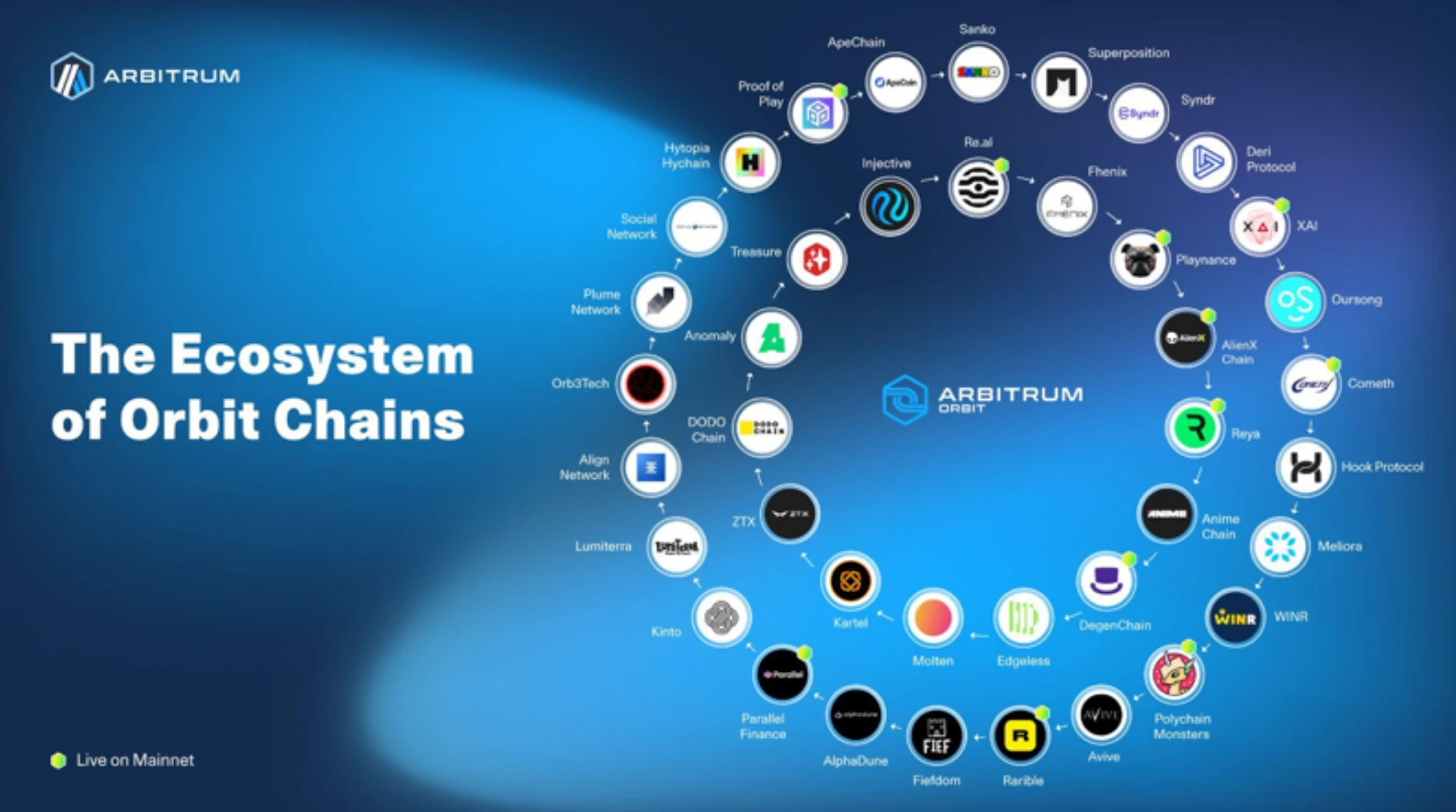

以太坊变得更快更便宜

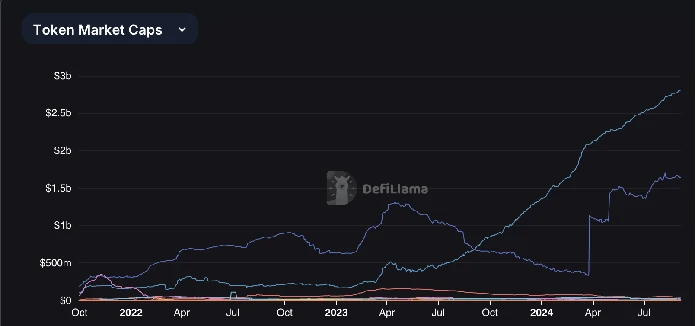

那么, 2024 年有什么新变化呢?这是一张关于以太坊费用的图表,它们已经从 10 到 50 美分之间下降到低于 1 美分,基本上同时为零。与此同时,Optimism 和 Arbitrum 这两个主要的以太坊 Laeyr 2 已经达到了一个重要的安全里程碑,称为阶段 1 ,多个基于 ZK 的 Rollup 也告诉我,他们计划很快达到阶段 1 。因此,Rollup 也很快会变得更安全。

费用的问题实际上已经解决了,但这并不是唯一重要的事情。

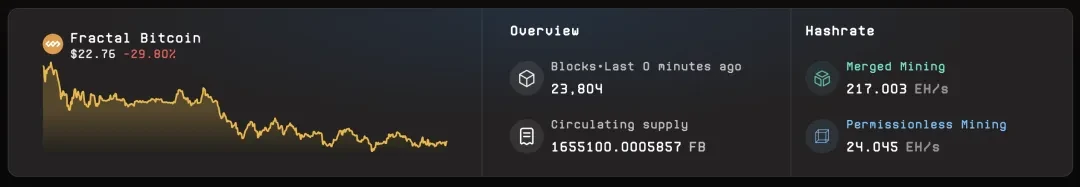

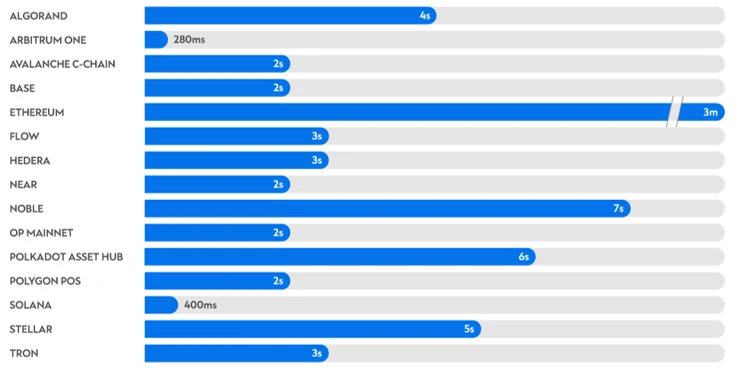

我清楚地记得在阿根廷旅行时遇到的另一个烦恼是,我试图用以太坊主网给一个人转账,交易费用大约是 4 美元,交易确认大约花了 5 分钟。虽然这时 EIP-1559 已经上线,但当时用的钱包实际上并没有升级。

比特币区块每 10 分钟出块一次。所以你必须等待 10 分钟,甚至可能一个小时才能确认交易。从理论上讲,以太坊的区块确认时间为 13 秒,但由于 gas 的原因,市场可能会出现效率低下的情况,有时你必须等待完全随机的区块确认时间,可能是 5 分钟,甚至更长的时间才能让我们的交易被纳入。

但 EIP-1559 实际上基本解决了这个问题。如果你添加合并功能,那么合并功能所做的一件事就是,将下一次交易的平均等待时间缩短了一半。

有了以上两个升级,我们如今的交易确认时间在 5 到 15 秒内。如果使用具有快速免费确认的 Layer 2 解决方案,通常可以缩短到一秒钟。因此,基本上这两个主要问题是导致 2021 年中心化用户体验远远优于去中心化用户体验的最大因素。

加密不只是一种效率技术

但我们也可以看看应用程序的一般用户体验质量。如果查看我 2015 年发布的推文,那是一次关于黑客松的内容,里面提到了 Firefly,这是一个用于 Farcaster 和 Twitter、Lens 的客户端。如果你观察一下用户界面的质量,那么看起来和 Web2 产品的质量没什么差距,但它是一个基于去中心化的应用程序。

今年我们也看到了账户抽象方面的进步。我们看到越来越多的人使用安全协议。我们看到了 EIP-7702 。我们开始看到 ZK-snarks 的主流应用,各种不同的应用程序,我们还有了新的、更好的隐私协议。还有零知识证明,我可以证明这是你的知识,你可以拥有一个护照并且充分使用它,甚至可以用于现有 Layer 2 之间易用性改进。

两年前,每个人都在抱怨需要手动切换网络。今天,我觉得至少在过去一年里,我实际上没有手动切换过网络。因此,技术的局限性曾是一个阻碍因素。我甚至记得那个时刻,当时 CryptoKitties 看起来可能会成为一个真正的出圈应用,但后来发生了什么呢?CryptoKitties 的成功将以太坊的 Gas 价格推高到了 50 。

以太坊变得基本上无法使用,这确实限制了其增长。但如今不会在出现这种情况,这基本上意味着一个不使用加密货币的理由不存在了。那么,还有什么使用加密的理由呢?我认为人们有时会犯的一种错误,是一直谈论加密 SDK 和将加密视为一种效率技术。这是很多人在 10 年前谈论过的事情。

2013 年比特币的好处被宣传有哪些好处?让付款变得容易、安全控制你的资金、零或更低的费用、保护个人身份等等。这四项中,有两项是我认为非常独特的加密货币特征。另两项曾经是加密货币独有的,但现在是否仍然如此呢? 如今我们有 Venmo,还有一些更好的支付方式,例如微信支付。

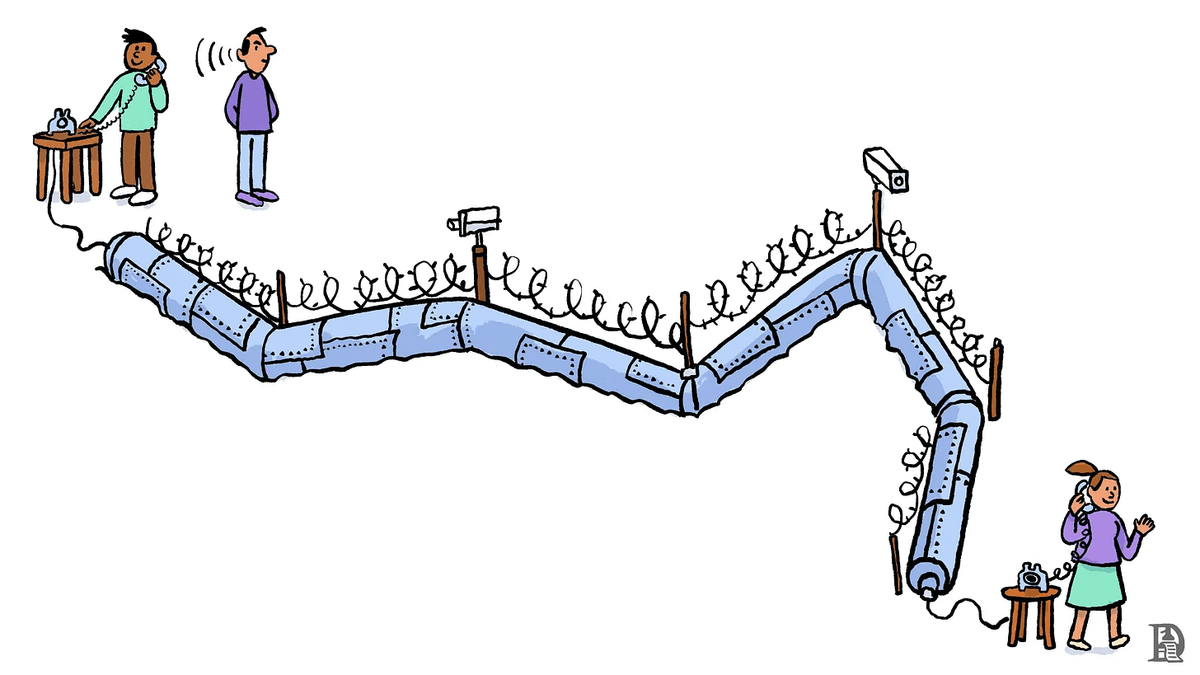

中心化系统方案越来越好,但在某些地方,支付和融资渠道获取仍然非常困难。为什么说困难呢?这不是因为技术的问题,这主要是因为全球政治的限制。所以我认为重要的是要记住,加密货币给世界带来的好处并不与同类技术进步绑定。这与从普通喷气式飞机转换为超音速喷气式飞机的技术改进一样,虽然都是飞机,但已经是一种不同类型的技术。

那么,具体是什么样的技术呢? 一种看法是参考约什·斯塔克 (Josh Stark) 在以太坊基金会撰写的这篇博客文章,发表于大约两年前。文章标题为《Atoms, Institutions, Blockchains》。其论点是,区块链使我们能够创造一种数字上的坚固性,这使我们能够创建难以改变的持久数字结构。

这些结构是坚固的,并且不会被破坏,就像用混凝土制成的物理结构。区块链和以往的网络技术有什么区别呢?在以往的网络中,如果你的文件共享网络崩溃了,那也没关系,你只需切换到另一个网络,过一周,大家就会忘记。但在区块链里如果一个锁定机制崩溃了,而你切换到另一个,大家就会失去所有的钱。这是一个根本性的区别。

区块链使互联网不仅可以弥补整体结构的弱点,而且实际上可以更好地构建能够解决类似问题的替代方案。

区块链是数字化的混凝土,可以用来建造虚拟的天空之城,那么这里有谁看过《天空之城》这部电影吗?

我认为这部电影真的很棒,我认为这绝对是吉卜力工作室最好的作品之一,我至少看过五遍。但事实证明,这部电影在某种程度上也意外地成为了以太坊的灵感来源,虽然我自己也没意识到。

2013 年,我在浏览维基百科的虚构元素列表时发现了 Ethereum(以太坊)。这个名字真的很棒,它让我想起了 19 世纪的一个科学理论。两个月后,以太坊基金会之前的一位组合设计师决定用这颗钻石作为以太坊的标志。当时我觉得这是一颗很酷的钻石,我喜欢这个标志,它很漂亮。

7 年后,当我第一次看见这部电影,我发现他们也有以太坊晶体。以太坊晶体实际上就像钻石一样。以太坊看着就像空中数字城堡一样,我认为加密货币中严肃与有趣的方面是结合在一起的,这也是我希望人们记住的。城堡可以保护你,保护你的家人,保护你的社区,城堡也可以是迪斯尼乐园的城堡,让你的社区玩得开心;城堡也可以是迪士尼乐园中的城堡,让你的社区享受乐趣;城堡还可以是一个博物馆,保存你文化的千年历史。城堡同样可以是所有这些东西,各种类型的数字城堡我们都可以在以太坊之上建造。

区块链需要满足主流采用需求——以钱包安全为例

那么,在完成这些建设之后,我们需要满足主流采用的需求,同时我们需要坚持开源和去中心化价值观。这是什么意思?例如钱包安全。

从历史上看,基本上有两种方法来保管你的资金:

第一种方法是比较疯狂的自我保护主义。你写下一个助记词,你所有操作都离线进行。你把助记词刻在一块钛金属上,然后把钛金属放进一个更坚固的钛金属锁箱里,然后把这个锁箱埋在地下 10 米深的地方,这样你的币就安全了。这是一种方法。

另一种方法是你可以将你的币交给一个值得信赖的人。你知道有这么一个好人,他的名字叫山姆。他和克林顿一起出席活动,他一定值得信赖。但两年后,结果证明你对谁值得信赖、谁不值得信赖的判断有点错误。

我认为这不是仅有的两种选择。如果你想要保护自己免受中心化的侵害,那么你可以做传统的自我托管,例如前面所说的将助记词放在钛金属里,然后埋到地下 10 米处。如果你想两者兼而有之,那么该怎么办呢?

这就是多重签名安全的智能钱包的重要性。多重签名安全意味着你有多个密钥,例如你可能有 6 个密钥,而发送交易时需要 4 个。你甚至可以设定一个规则,对于小额交易只需要一个密钥。这些密钥可以是你能够控制的任何组合,包括朋友和家人等。

如今,您实际上可以创建一个简单的真实账户,这是一个智能合约钱包,只有当您生成一个证明,证明您控制着特定电子邮件地址时,您才能从中发送交易。因此,现在基本上可以将 Web2的社交恢复功能引入 Web3的世界。在 Web3的世界中,你甚至可以多样化你的信任。

因此,您可以通过一家美国公司对 Gmail 帐户进行 zk 包装,然后您可以将其结合起来变成由 CK 包装,同时您也可以通过一家中国公司制造的硬件钱包制作三个密钥。如此,您甚至可以获得机构级信任的好处,而没有很多弱点。Forecast 在用户体验上是一款 Web2 应用程序,但用户可以设置恢复地址,未来可能的是通过多重签名可以控制自己的帐户。我个人对自己多重签名账户信任程度远远高于任何一个中心化账户。

去中心化与实用性兼顾

这有一个基于以太坊的演示钱包,但它的用户体验与 Venmo 相同。通过某种机制,用户可以证明他们的提款来自一些存款,而无需透露是哪一笔,但可以证明他们的存款不是来自坏人。因此,这是一种让普通用户拥有非常高隐私度的方法,可以满足很多重要的需求,但实际上并没有后门。

例如,对于 ZK 社交媒体,可以使用一个类似超级账户。我们可以证明您是社区的一员,为遇到问题的人提供证明或解决声誉问题,同时仍然保护他的隐私。这不需要用户在场,不需要有人相信您或需要 KYC 来验证您。我们可以同时拥有隐私和信任。

在以太坊主网,许多技术改进正在发生,使得 Layer 1 在减少最终确认时间、增加容量的同时,更加去中心化且易于验证。这些事情已经在发生。这些都是以太坊生态系统和我认为加密货币在未来 10 年将要发展的方向。

现在我们基本上有两条错误的道路,一条是牺牲实用性以换取去中心化,永远成为一个只对自己有吸引力的生态系统。它只有 695 个用户。另一条糟糕的道路是牺牲去中心化以换取实用性,然后试图说服自己这是没办法的选择。

所以下一个伟大的加密应用程序我们必须要用一个“漂亮”的 Gmail 帐户去登录吗?我们并不是必须要在这两种黑暗选项中做出决定,我们可以同时拥有去中心化和实用性。