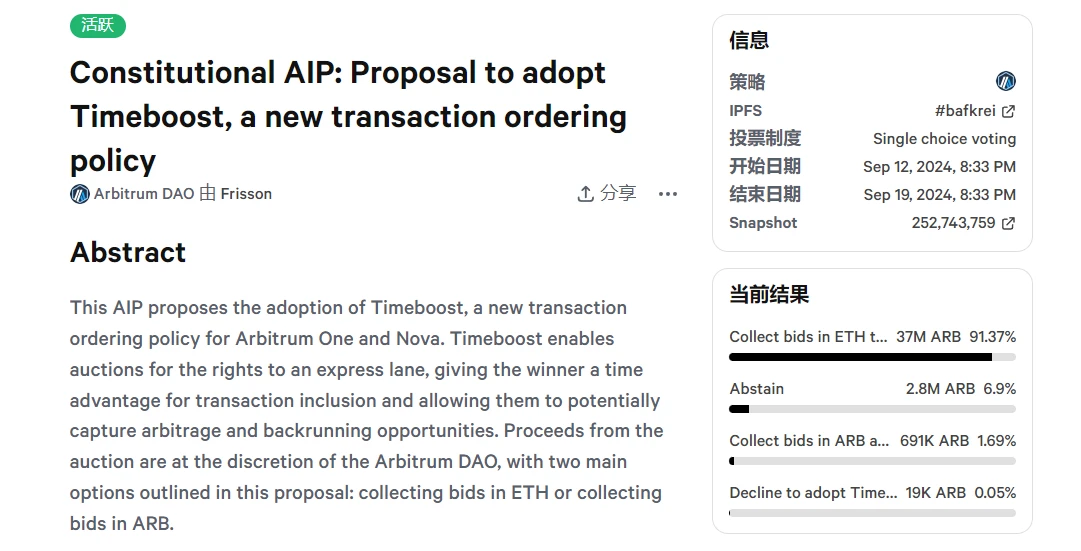

OKX 联合优质数据平台 AICoin 发起系列经典策略研究,旨在通过数据实测和策略特点等核心维度分析,帮助用户更好地了解和学习不同的策略,尽量避免盲目使用。

本文是策略实测完结篇,旨在通过总结前 5 期核心内容,帮助用户一文看懂 8 大经典交易策略。这些策略总结展示了不同策略在特定市场环境中的表现和应用场景。交易者应根据自身的风险承受能力和市场判断选择适合的策略,并持续优化策略以应对市场变化。

1. 定投策略

定投策略是一种通过在固定的时间间隔内以固定金额交易的方式,分散一次性大额交易的风险,并利用时间复利效应实现收益最大化的策略。该策略尤其适合长期持有者,旨在降低市场波动带来的心理压力和交易风险。

数据样本

通过对比特币在不同减半周期内的定投收益进行分析,结果显示,定投策略在各周期的胜率均超过 50% ,尤其是在第二次减半至第三次减半期间,定投策略的收益率达到 170.03% 。然而,这一收益率与比特币市场整体涨幅相比仍显逊色。对于近四年的定投数据样本 显示, 2022 年的定投收益率为-48.75% ,显现了在熊市中定投策略可能带来的风险。

优势与劣势

优势:定投策略通过分散交易时间降低了市场波动的影响,适合心理抗压能力较低的交易者。它具有操作简易和较低风险的特点,尤其适合长期交易者。

劣势:定投策略无法在市场的急剧上涨中最大化收益,而且需要长期坚持,面对较长的市场低迷期时,收益可能较低。

策略策略总结

定投策略在波动较大的市场中提供了一种相对稳健的交易方式,但在市场趋势明确时,定投策略可能无法捕捉到最大涨幅。交易者在使用该策略时,需结合市场环境和个人交易目标进行调整。

2. 网格策略(现货与合约)

网格策略是一种通过在预设的价格区间内划分多个网格,并在价格波动时执行买入和卖出操作的策略。此策略主要适用于震荡市场,通过频繁的小额交易来实现稳定收益。

数据样本

在对中性合约网格和现货网格的实测中,数据显示,中性合约网格在震荡向上市场中的收益率最高,达到 33.91% ,而现货网格在相同市场条件下的收益率为 19.05% 。然而,在震荡向下的市场环境中,现货网格出现了亏损,显示出其在下跌市场中的局限性。

优势与劣势

优势:网格策略在震荡市场中表现出色,尤其是中性合约网格,通过利用杠杆和频繁交易,实现了较高的收益率。其灵活性强,适应性高。

劣势:网格策略在单边市场中表现不佳,尤其是现货网格,容易在下跌市场中出现亏损。此外,合约网格策略虽然收益高,但伴随着更高的风险。

策略总结

网格策略在震荡市场中提供了一种有效的收益方式,特别是中性合约网格,在不同市场环境下均表现良好。但交易者需谨慎使用杠杆,并注意市场的单边趋势对策略的潜在影响。

3. 马丁格尔策略(现货与合约)

马丁格尔策略是一种通过在亏损后加倍交易规模以摊低成本,并期待通过最终盈利弥补所有损失的高风险策略。该策略适用于有较强资本实力的交易者,并在震荡或上涨市场中表现较好。

数据样本

在不同市场环境下,现货马丁格尔和合约马丁格尔的实测数据显示,两者在上涨市场中均能获得可观收益,尤其是合约马丁格尔在横盘震荡市场中表现优异。然而,在下跌市场中,两者均面临较大的亏损风险,尤其是合约马丁格尔,由于杠杆的使用,风险更为显著。

优势与劣势

优势:马丁格尔策略通过不断加仓降低平均成本,在震荡和上涨市场中具有较高的盈利潜力,尤其是合约马丁格尔策略,通过杠杆效应放大收益。

劣势:该策略的主要风险在于市场持续下跌时可能导致巨大的亏损,尤其是杠杆交易中的爆仓风险。此外,马丁格尔策略需要较强的心理承受能力和资金支持。

策略总结

马丁格尔策略在适当的市场环境中能够带来显著的收益,但其高风险特性决定了只有具备足够风险承受能力和资金实力的交易者才能有效使用。在单边下跌市场中,交易者应谨慎使用该策略,或考虑调整策略以降低风险。

4. 资金费套利策略

资金费套利策略是一种通过利用期货合约和现货之间的资金费率差异来获利的策略。该策略适用于市场波动较小且资金费率显著的市场,旨在通过锁定资金费率差异实现稳定收益。

数据样本

在不同市场条件下,资金费套利策略的实测显示,在资金费率较高的情况下,该策略能够实现稳定的年化收益。然而,当市场波动较大,或资金费率出现异常波动时,策略的收益可能受到影响。

优势与劣势

优势:资金费套利策略通过锁定资金费率差异,提供了一种相对稳定的收益方式,尤其在市场波动较小时表现尤为突出。其风险相对较低,适合长期交易。

劣势:该策略对市场条件的依赖较大,尤其是在资金费率波动较小的市场中表现良好。但在资金费率波动较大或出现异常时,可能难以实现预期收益。

策略总结

资金费套利策略提供了一种在低波动市场中的稳定收益方式,适合风险厌恶型交易者。然而,交易者需密切关注市场的资金费率变化,并在必要时调整策略以应对市场波动带来的风险。

5. 时间加权和冰山委托策略

时间加权策略和冰山委托策略是两种常见的交易策略,适用于大额订单的拆分和执行。时间加权策略通过将大订单分散在指定时间内执行,减少市场冲击;冰山委托策略则通过分批挂单隐藏大订单的实际规模,避免市场价格剧烈波动。

数据样本

时间加权策略在牛市中通过分批买入降低了市场冲击,获得了较好的更好的收益;在熊市中,通过设置吃单限制价,避免了过高接盘,从而降低了亏损风险。冰山策略在牛市中有效隐藏了大买单的实际规模,避免市场推高价格;而在熊市中,则通过隐藏大卖单的实际规模,避免市场恐慌性抛售。

优势与劣势

优势:时间加权策略通过分散订单执行时间,减少市场冲击,价格平滑且可控性高。冰山委托策略则通过隐藏订单规模,保护交易隐私,适应性强。

劣势:时间加权策略在市场剧烈波动时可能无法获得最佳价格,且可能被识别和狙击。冰山委托策略则存在流动性风险,且易被高级算法识别。

策略总结

时间加权和冰山委托策略为大额订单的执行提供了有效的解决方案,特别适用于市场波动较大或流动性较差的环境。交易者在使用这些策略时,需结合市场环境和个人需求,灵活调整策略参数,以实现更佳交易效果。

如何访问 OKX 策略交易?

用户可以通过 OKX APP 或者官方网站,进入「交易」板块的「策略交易」模式,然后点击策略广场或者创建策略都即可开启体验。除了自行创建策略,目前策略广场还提供“优质策略”和“策略带单员的优质策略”,用户可以复制策略或者进行策略跟单。

OKX 策略交易具有操作简易、低手续费和安全保障等多重核心优势。在操作方面,OKX 提供智能参数助力用户更科学的设置交易参数;并提供图文及视频教程,让用户快速上手并精通。在手续费方面,OKX 对手续费率体系进行了全面升级,大幅降低用户交易手续费。在安全保障方面,OKX 拥有全球顶级专家组成的安全团队,可以为您提供银行级的安全保护。

如何访问 AICoin 的策略?

用户可以在 AICoin 产品的左侧边栏的「策略」选项中找到网格交易策略、全币种 DCA 策略、资金费套利策略;在左侧边栏的「行情」选项中找到 AI 网格策略、现货 DCA 策略;在「行情」界面「自定义指标/回测/实盘」里找到定投策略、合约 DCA 策略;在「行情」界面右侧边栏「交易」里找到智能拆单策略

AICoin 策略广场精选各类优质策略,其中套利机器人具备低风险和收益稳健的特性,AI 网格具备极速捕捉差价能力,全币种 DCA 拥有均摊成本和分批抄底全市场币种的优点,因而适合各类投资者使用

数据实测系列汇总

免责声明

本文仅供参考,仅代表作者观点,不代表 OKX 立场。本文无意提供 (i) 交易建议或交易推荐; (ii) 购买、出售或持有数字资产的要约或招揽; (iii)财务、会计、法律或税务建议。我们不保证该等信息的准确性、完整性或有用性。持有的数字资产(包括稳定币和 NFTs)涉及高风险,可能会大幅波动。您应该根据您的财务状况仔细考虑交易或持有数字资产是否适合您。有关您的具体情况,请咨询您的法律/税务/交易专业人士。请您自行负责了解和遵守当地的有关适用法律和法规。